前言

最近,deepseek非常火爆,不管是媒体 还是个人用户都在疯狂涌入,导致Deepseek官网的连续对话几乎不可用,但是很多朋友又有使用需求,相较于成本高昂、对话次数限制的o3mini 显然是deepseek更方便。于是很多朋友就听信部分流媒体平台所说的,使用CPU推理、电脑本地部署deepseek可以代替官方之类的话,今天做这个选题就是为了告诉大家,本地能部署的deepseek几乎无法满足任何生产力需求。【本文章不是正向宣传的选题】

部署流程

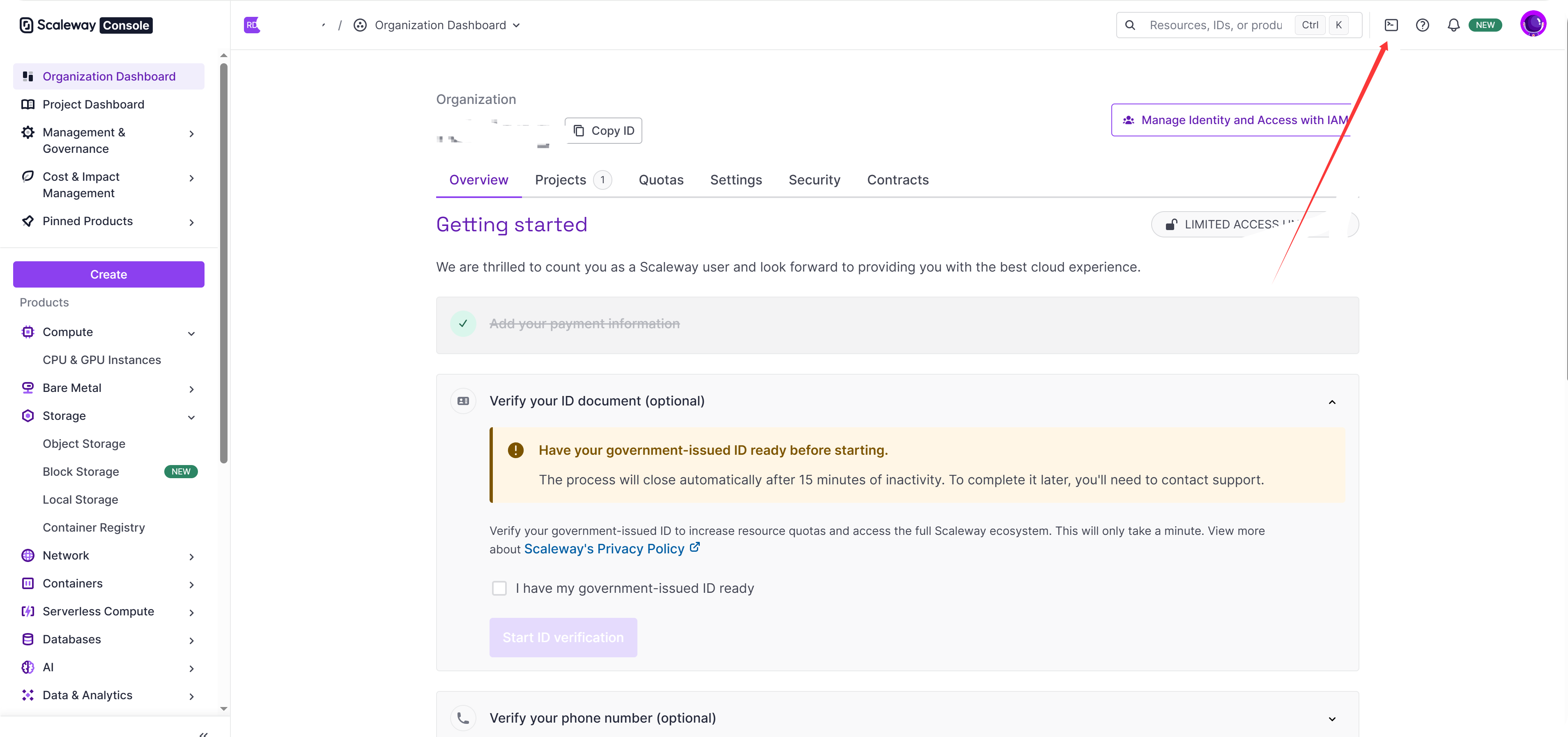

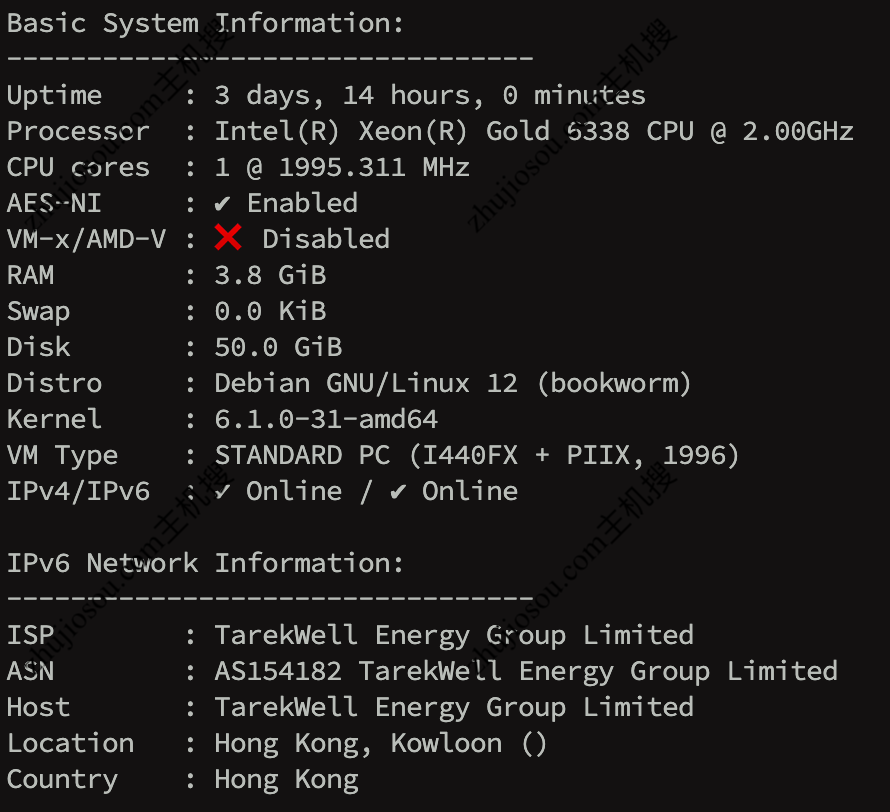

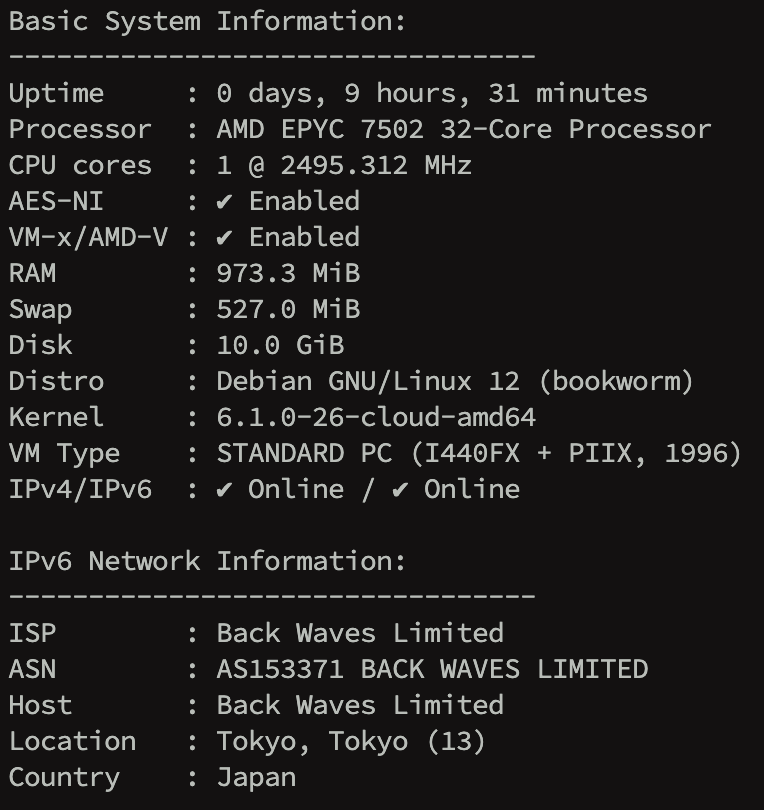

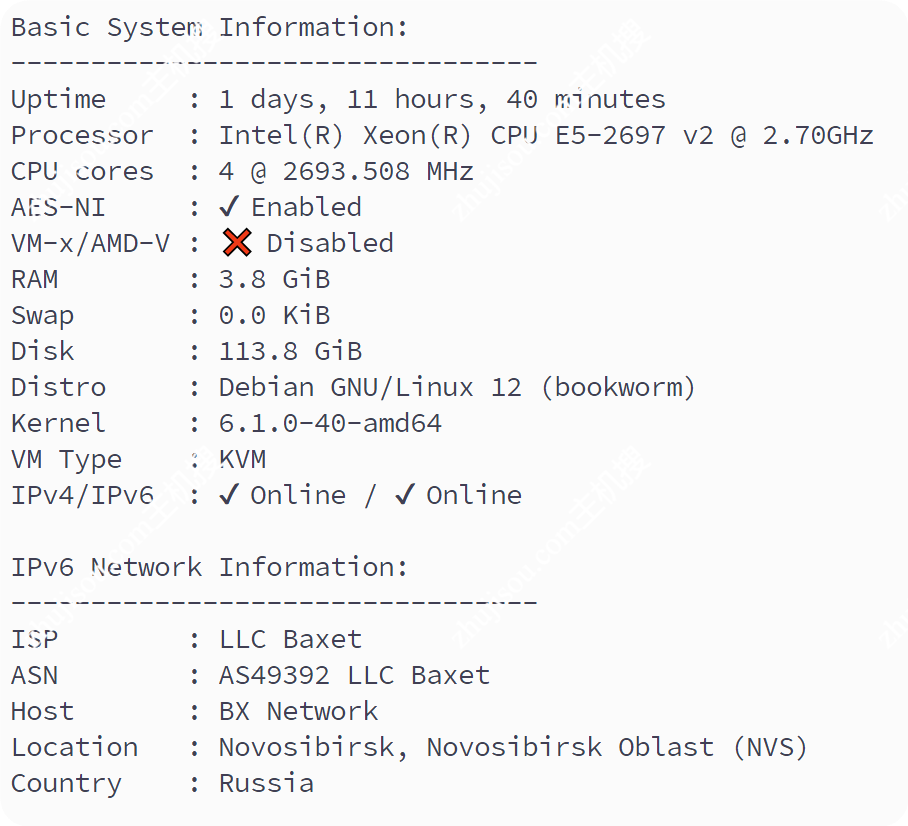

部署环境介绍

首先给大家介绍下本次部署环境,由于博主前一段时间测评的几个德国机器配置都相当不错,并且博主实在是不愿意在本地跑ollama,所以这次选择的运行环境是:https://zhujisou.com/1090.html、https://zhujisou.com/1139.html 这两篇文章测评的两台德国机器【注 ITGARAGE有跑路风险,请勿再新购】

他们的配置分别是4核12900k 8G内存和2核E5-2690V4 4G内存。前者会被用于7b、8b蒸馏版的部署,后者则部署1.5b版。

安装ollama

由于ollama已经提供了一键安装的脚本,所以在ollama官网下载页面(https://ollama.com/download/linux)直接选择对应的系统 复制命令在VPS中运行即可

![【探索折腾】云端低成本部署蒸馏版DeepSeek [附1.5|7|8b简单测试]-主机搜](https://zhujisou.com/wp-content/uploads/2025/02/2025021205540739.png)

我就帮大家直接复制过来好了:

curl -fsSL https://ollama.com/install.sh | sh

![【探索折腾】云端低成本部署蒸馏版DeepSeek [附1.5|7|8b简单测试]-主机搜](https://zhujisou.com/wp-content/uploads/2025/02/2025021205565070.png)

运行结束后,可以看到 Ollama给出了API请求地址 VPSIP:11434,如果有需要 可以对接到各种微信、QQ机器人或者oneapi对接到各种对话应用中去。

安装docker[为安装webui做准备]

首先说,docker在本次测试中并非必须,只是单纯为后面webui的安装做准备,如果没有这个需求可以忽略这部分

【此部分内容 参考[Docker — 从入门到实践] https://yeasy.gitbook.io/docker_practice/install/ 】

首先要检查下系统中是否存在旧版的docker或者docker-engine,如果有就先卸载。卸载完成后开始安装。

如果是国内VPS,使用第一个命令 使用国内源安装,非大陆地区可以直接使用默认的源,并且添加软件源的 GPG 密钥

curl -fsSL https://mirrors.aliyun.com/docker-ce/linux/debian/gpg | sudo gpg --dearmor -o /usr/share/keyrings/docker-archive-keyring.gpg # 官方源 curl -fsSL https://download.docker.com/linux/debian/gpg | sudo gpg --dearmor -o /usr/share/keyrings/docker-archive-keyring.gpg

然后,我们需要向 sources.list 中添加 Docker 软件源:

echo \ "deb [arch=amd64 signed-by=/usr/share/keyrings/docker-archive-keyring.gpg] https://mirrors.aliyun.com/docker-ce/linux/debian \ $(lsb_release -cs) stable" | sudo tee /etc/apt/sources.list.d/docker.list > /dev/null # 官方源 echo \ "deb [arch=amd64 signed-by=/usr/share/keyrings/docker-archive-keyring.gpg] https://download.docker.com/linux/debian \ $(lsb_release -cs) stable" | sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

接下来更新 apt 软件包缓存,并安装 docker-ce。

sudo apt-get update sudo apt-get install docker-ce docker-ce-cli containerd.io

启动、运行docker

sudo systemctl enable docker sudo systemctl start docker

下载并运行模型

![【探索折腾】云端低成本部署蒸馏版DeepSeek [附1.5|7|8b简单测试]-主机搜](https://zhujisou.com/wp-content/uploads/2025/02/2025021206080437.png)

在ollama官网中选择需要运行的模型,点击进入复制运行命令即可。

![【探索折腾】云端低成本部署蒸馏版DeepSeek [附1.5|7|8b简单测试]-主机搜](https://zhujisou.com/wp-content/uploads/2025/02/2025021206091458.png)

选择模型的参数大小,对于r1来说,小模型全部是采用开源模型蒸馏而成,关于模型蒸馏,如果有不理解的效果版可以参考此文章——>【】

开始下载运行1.5b的deepseek小模型

![【探索折腾】云端低成本部署蒸馏版DeepSeek [附1.5|7|8b简单测试]-主机搜](https://zhujisou.com/wp-content/uploads/2025/02/2025021206123814.png)

由于参数量小,下载速度很快哈,现在就可以开始对话了

对话与效果对比

![【探索折腾】云端低成本部署蒸馏版DeepSeek [附1.5|7|8b简单测试]-主机搜](https://zhujisou.com/wp-content/uploads/2025/02/2025021206160530.png)

![【探索折腾】云端低成本部署蒸馏版DeepSeek [附1.5|7|8b简单测试]-主机搜](https://zhujisou.com/wp-content/uploads/2025/02/2025021206160742.png)

![【探索折腾】云端低成本部署蒸馏版DeepSeek [附1.5|7|8b简单测试]-主机搜](https://zhujisou.com/wp-content/uploads/2025/02/2025021206160692.png)

![【探索折腾】云端低成本部署蒸馏版DeepSeek [附1.5|7|8b简单测试]-主机搜](https://zhujisou.com/wp-content/uploads/2025/02/2025021206160772.png)

安装webui[可选]

总结与建议

从对话效果中可以看出来,问的都是对正常大模型非常基础的问题,1.5b的三个回答都非常的离谱(上图中没有标注的即为1.5b版),非常简单的鸡兔同笼问题无法解决 因为思考过程中认为兔子只有2条腿 甚至思考中开始怀疑兔子是不是有两个头....

7b和8b可以成功列出鸡兔同笼的方程式并解答,但是在面对一个涉及到中文语义理解的中译英的问题,两者一个认为冬天要少穿 夏天要多穿,一个认为这句话是在说穿衣的样式。

我个人是认为,7b、8b的模型 在加上向量数据库后,可以对接微信或者QQ机器人,回答一些简答的客户问题,或者伪装在线客服,反正纯CPU推理速度也就在1token/s左右,挺像是人工客服打字慢慢回来着。

如果正儿八经的需要生产力的臂助,可以考虑在scnet、autodl部署32b、70b的版本,或者使用目前成本相对较低、api可用性强于deepseek官方的硅基流动(这家也提供了很多公益的小模型api免费用)

评论 (0)